- Введение

- Топология NUMA

- Отличия топологий

- Настройка NUMA для ВМ

- Примеры настройки

- Кейсы из жизни

- Поддержка NUMA

- SSD-кэширование

- NVMe RAID

- Рекомендации

- FAQ

Аппаратное разграничение ресурсов: NUMA, SSD cache, NVMe RAID

Введение

Аппаратное разграничение ресурсов — это основа эффективной, безопасной и предсказуемой работы сложных вычислительных систем. Эта методология выходит за рамки программных ограничений и обеспечивает управление доступом к критически важным компонентам, таким как память, хранилище и процессорные ядра, на уровне физической инфраструктуры. Три ключевые технологии — NUMA, SSD-кеширование и аппаратные RAID-массивы на NVMe — формируют современный подход к решению проблем производительности и надежности. В условиях растущих нагрузок от виртуализации, баз данных и высокопроизводительных вычислений правильное понимание и настройка этих механизмов напрямую определяет отзывчивость системы, её масштабируемость и безопасность данных.

Топология NUMA: общие сведения

NUMA расшифровывается как Non-Uniform Memory Access — неоднородный доступ к памяти. Это архитектура памяти для многопроцессорных систем, в которой время доступа к памяти зависит от её физического расположения относительно конкретного процессора. Внутри такого сервера память физически разделена между процессорами или их группами (узлами). Процессор может обращаться к «своей» локальной памяти с максимальной скоростью, а для доступа к памяти, привязанной к другому узлу, требуется больше времени, так как запрос должен пройти через межсоединение (например, Intel QPI или AMD Infinity Fabric). Основная задача NUMA — устранить «узкое место», возникающее в классических SMP-системах (UMA), где все процессоры конкурируют за доступ к единой общей шине памяти.

Суть и значения архитектуры заключаются в оптимизации. Разработка эффективных алгоритмов распределения памяти и планирования задач в операционных системах позволяет привязать вычислительные потоки к тем процессорам, рядом с которыми расположены обрабатываемые ими данные. Это сводит к минимуму количество медленных удалённых обращений, что критически важно для ресурсоёмких приложений: виртуальных машин высокого класса, серверов баз данных (СУБД), систем рендеринга и сложных научных симуляций.

Отличия базовой и NUMA топологии

Ключевое различие между традиционной UMA и NUMA архитектурой заключается в принципе доступа. В UMA все процессоры имеют равные и одинаковые по времени доступ к единому пулу памяти через общую шину или коммутатор. Это просто реализовать, но с увеличением числа процессоров шина становится перегруженной, ограничивая производительность и масштабируемость.

В топологии NUMA память неоднородна. Каждый узел представляет собой относительно автономную подсистему с собственными процессорами, контроллерами памяти и локальным ОЗУ. Это позволяет системе масштабироваться, добавляя новые узлы, при этом основная работа приложений, спроектированных с учётом локальности данных, выполняется внутри одного узла. Однако если задача требует частого обращения к данным, распределённым по разным узлам, производительность может снизиться из-за высокой латентности межсоединений. Поэтому грамотная настройка и осведомлённость о топологии — обязательны для администратора.

Настройка виртуальной топологии NUMA для ВМ

Виртуализация добавляет уровень абстракции, но не отменяет физических реалий NUMA. Гипервизор должен корректно транслировать топологию физического хоста на виртуальные машины. Современные платформы виртуализации, такие как защищённый гипервизор Xen, используемый в Numa vServer, позволяют назначать виртуальным машинам несколько виртуальных процессоров, но при этом важно учитывать их привязку к физическим узлам NUMA.

Для этого существуют специальные политики размещения. Идеальная конфигурация предполагает, что все виртуальные процессоры ВМ и выделенная ей память размещаются в пределах одного физического узла NUMA. Это гарантирует локальный доступ и максимальную производительность. Если же ВМ требует больше ресурсов, чем может предоставить один узел, её конфигурацию осознанно распределяют между несколькими узлами, понимая потенциальные потери на удалённом доступе. Средства управления, вроде интерфейса Numa vServer, предоставляют администратору инструменты для такой настройки, мониторинга и оптимизации распределения ресурсов в реальном времени.

Примеры настройки топологии NUMA

Рассмотрим практический пример. На сервере с двумя узлами NUMA (по 16 ядер и 128 ГБ ОЗУ каждый) развёрнута критически важная ВМ для СУБД. Правильная настройка: явно указать гипервизору разместить все 8 виртуальных процессоров ВМ на ядрах узла 0 и выделить ей 64 ГБ памяти из локального ОЗУ того же узла. Это обеспечит минимальные задержки доступа.

Неправильная настройка: позволить гипервизору динамически перемещать процессы ВМ между всеми 32 ядрами хоста, при этом выделив 96 ГБ памяти, что физически распределит её между обоими узлами. В такой конфигурации половина или более обращений к памяти будут удалёнными, что может снизить быстродействие СУБД в разы, особенно под высокой нагрузкой. Операционные системы, включая современные ядра Linux и Windows Server, имеют встроенные средства (numactl в Linux, политики в Windows), которые помогают администратору правильно управлять размещением.

Кейсы из жизни: когда NUMA помогает

Влияние NUMA на производительность наиболее заметно в высоконагруженных средах.

Позитивный кейс: Крупная компания столкнулась с непредсказуемыми замедлениями в системе ERP на виртуальной платформе, особенно во время массовой обработки транзакций. Анализ показал, что ВМ с сервером приложений «размазана» по нескольким узлам NUMA. После переконфигурации и «стягивания» виртуальных ресурсов ВМ в границы одного физического узла среднее время отклика критичных операций сократилось на 40%, а стабильность работы возросла. Это прямое следствие минимизации латентности памяти.

Негативный кейс: В другом случае ИТ-отдел решил сэкономить, запустив на одном мощном сервере с четырьмя узлами NUMA несколько десятков разных ВМ. Однако из-за отсутствия внятной политики размещения и мониторинга нагрузка на межсоединения между узлами стала аномально высокой. В результате общая производительность всего парка ВМ оказалась ниже, чем на менее мощных, но правильно настроенных серверах. Возросла и задержка сетевого взаимодействия между ВМ, что негативно сказалось на распределённых приложениях.

Поддержка NUMA в системах

Современные операционные системы и гипервизоры имеют развитую поддержку NUMA. Ядро Linux, начиная с версии 2.5, постоянно развивает и совершенствует механизмы автоматического балансирования памяти между узлами и привязки процессов. Windows, особенно серверные редакции, также предоставляет API и средства для управления топологией. Важным аспектом является NUMA в Windows и других ОС на уровне драйверов и планировщика, которые стремятся размещать потоки и выделять память в пределах одного узла.

Виртуализационные платформы, такие как Numa vServer на базе Xen, и их конкуренты (VMware vSphere, Microsoft Hyper-V) глубоко интегрировали осведомлённость о NUMA в свои ядра. Они способны не только учитывать топологию при первоначальном размещении ВМ, но и динамически корректировать распределение ресурсов, отслеживая метрики производительности и латентности доступа к памяти для работающих виртуальных машин. Эта интеграция критически важна для обеспечения предсказуемой высокой производительности в виртуальных средах.

SSD-кэширование: ускорение дисковых подсистем

SSD-кэширование (flash caching) — это аппаратная технология, использующая быстрые твердотельные накопители (SSD) в качестве буфера для часто запрашиваемых данных основной, более медленной дисковой подсистемы, построенной, как правило, на HDD. Она позволяет существенно повысить производительность хранилища для рабочих нагрузок со случайными операциями чтения и записи, оставаясь при этом экономически эффективной альтернативой массивам из одних SSD (all-flash).

Как работает SSD-кеш? Он функционирует как промежуточный уровень (часто называемый кэшем второго уровня, L2 Cache) между оперативной памятью сервера (кэш L1) и основными массивами HDD. Система автоматически, на основе алгоритмов отслеживания, определяет «горячие» блоки данных — те, к которым происходят повторные обращения. Эти блоки перемещаются на быстрый SSD. Все последующие запросы к этим данным обслуживаются уже с SSD, что дает многократный прирост в скорости и снижение задержек (латентности) по сравнению с обращением к HDD. Например, по данным одного вендора, добавление SSD кеша может увеличить количество операций ввода-вывода в секунду (IOPS) при случайном доступе более чем в 15 раз и сократить среднюю задержку на 93%.

Для кэширования используются специальные алгоритмы замещения данных, такие как LRU (Least Recently Used — вытесняются давно неиспользуемые данные), LFU (Least Frequently Used — вытесняются редко используемые) или их гибриды. Это позволяет оптимизировать заполнение ограниченного пространства быстрых накопителей наиболее полезными данными. Продвинутые реализации, как в RAIDIX, разделяют кэш на области для чтения (RRC) и записи (RWC), что позволяет независимо оптимизировать политики для разных типов нагрузки и снизить износ SSD.

Эффективность SSD-кэширования максимальна в средах с высокой пространственной локальностью данных, где относительно небольшой объём информации запрашивается многократно. Это характерно для виртуальных сред, файловых серверов, веб-серверов и систем управления базами данных. Для преимущественно последовательных операций (например, запись потокового видео) или при полностью случайной нагрузке без повторных обращений польза от кэша будет невелика.

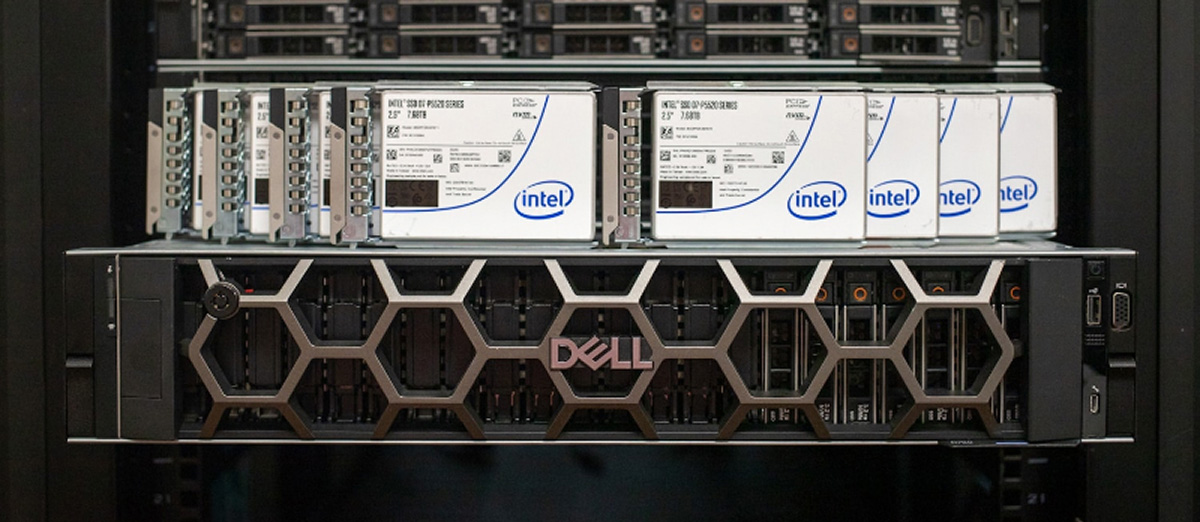

Аппаратные RAID-массивы на NVMe для надёжности и скорости

RAID — это технология объединения нескольких физических накопителей в единый логический блок для повышения производительности, надёжности или их комбинации. С появлением сверхбыстрых протоколов NVMe, которые устраняют узкие места традиционных SATA и SAS, создание RAID-массивов на базе NVMe-дисков стало следующим логическим шагом для критически важных приложений, где важна как скорость, так и отказоустойчивость.

Современные аппаратные RAID-контроллеры, такие как LSI MegaRAID 9460-8i, представляют собой специализированные платы расширения с собственным процессором и памятью. Они полностью разгружают центральный процессор от задач по расчёту контрольных сумм, зеркалированию данных и управлению массивом, выполняя их на собственном аппаратном обеспечении. Это снижает задержки и накладные расходы ОС. Для системы такой контроллер представляет массив из нескольких NVMe-дисков как одно надёжное и высокопроизводительное блочное устройство (например, виртуальный SAS-диск).

Популярные уровни RAID для NVMe:

- RAID 0 (Stripe): Чередование данных между дисками. Максимальная производительность на чтение и запись, но полное отсутствие отказоустойчивости. Выход из строя одного диска ведёт к потере всех данных в массиве.

- RAID 1 (Mirror): Зеркалирование данных. Полная копия данных хранится на каждом диске массива (минимум два). Высокая надёжность и скорость чтения, но полезная ёмкость равна ёмкости одного диска.

- RAID 5: Чередование с контролем чётности. Требует минимум три диска. Обеспечивает хорошую производительность на чтение, приемлемую на запись и позволяет пережить отказ одного диска без потери данных.

- RAID 10 (1+0): Комбинация зеркалирования и чередования. Требует минимум четыре диска. Сочетает высокую производительность RAID 0 и отказоустойчивость RAID 1, позволяя в определённых конфигурациях пережить отказ более чем одного диска.

Программно-аппаратные гибридные решения, такие как Intel Virtual RAID on CPU (VROC), используют возможности чипсета и лицензионный ключ для создания массивов непосредственно на процессорных линиях PCIe, к которым подключены NVMe-диски. Это также эффективное решение, хотя его поддержка в стороннем ПО (например, некоторых гипервизорах) может быть ограничена по сравнению с классическими аппаратными контроллерами.

Применение NVMe RAID особенно оправдано для высоконагруженных серверных сред: виртуализации (хосты гипервизоров), высокопроизводительных баз данных, систем аналитики в реальном времени и любых задач, где задержки ввода-вывода являются основным ограничивающим фактором. Это обеспечивает аппаратное разграничение доступа к дисковым ресурсам на уровне контроллера, повышая как безопасность (изоляция массива от ОС), так и управляемость.

Выводы и рекомендации по управлению доступом

Эффективное аппаратное разграничение ресурсов — это не отдельная настройка, а комплексный подход к проектированию и эксплуатации ИТ-инфраструктуры.

Основные рекомендации:

- Анализ перед внедрением: Прежде чем настраивать NUMA или развёртывать SSD кеш, необходимо детально изучить профиль нагрузки целевых приложений. Инструменты мониторинга и профилирования (perf, Intel MLC, системные счётчики) помогут выявить узкие места.

- Приоритет локальности: Для NUMA главный принцип — сохранение локальности данных. ВМ и процессы должны работать с памятью, физически расположенной как можно ближе к выполняющим их ядрам. Используйте инструменты привязки (numactl, задачи планировщика ОС).

- Правильный выбор технологии: SSD-кеш — отличное решение для гибридных хранилищ со смешанной и повторяющейся нагрузкой. Аппаратный NVMe RAID — выбор для чистой, предсказуемой и максимальной производительности и надёжности. Осведомлённость о NUMA обязательна для всех многопроцессорных серверов.

- Мониторинг и тонкая настройка: После внедрения необходим постоянный мониторинг. Для NUMA — отслеживание соотношения локальных и удалённых обращений к памяти. Для SSD-кеша — эффективность попаданий в кэш (hit rate). Для RAID — состояние дисков и производительность массива.

- Использование интегрированных решений: Рассматривайте готовые защищённые платформы, такие как Numa vServer, которые изначально спроектированы с учётом оптимального управления аппаратными ресурсами, включая NUMA, и предоставляют удобные инструменты для их контроля в контексте виртуализации.

Часто задаваемые вопросы

Вопрос: Всегда ли включение NUMA в BIOS улучшает производительность сервера?

Ответ: Не всегда. Для однопроцессорных систем или для задач, которые не являются чувствительными к задержкам памяти и не оптимизированы для многопоточности, включение NUMA может не дать заметного эффекта или, в редких случаях из-за ошибочного размещения данных ОС, даже немного снизить его. Однако для современных многопроцессорных серверов, особенно под нагрузкой виртуализации или баз данных, корректная работа NUMA обычно критически важна.

Вопрос: Можно ли использовать SSD-кеш и аппаратный RAID одновременно?

Ответ: Да, и это мощная комбинация. Например, можно создать отказоустойчивый RAID-массив из HDD (уровень 5, 6 или 10) для хранения основного объёма данных и подключить к этому массиву SSD кеш для ускорения обработки «горячих» данных. Или, наоборот, создать высокопроизводительный NVMe RAID 1 или 10 для критически важных ВМ/БД, а для архива или реже используемых данных использовать гибридное хранилище с кэшем.

Вопрос: Что важнее для производительности виртуальной машины: больше виртуальных CPU или правильная настройка NUMA?

Ответ: В долгосрочной перспективе и для стабильной работы правильная настройка NUMA часто важнее. Назначение ВМ больше виртуальных процессоров, чем может эффективно обслужить один физический узел NUMA, приведёт к межсокетным задержкам и может сделать производительность непредсказуемой и низкой. Лучше выделить ВМ ресурсы в пределах одного узла, даже если их немного, но обеспечить ей минимальную латентность доступа к памяти.